En entornos empresariales, es común que los datos se encuentren dispersos en diferentes sistemas y plataformas. SharePoint es una plataforma popular utilizada para la colaboración y el almacenamiento de documentos en muchas organizaciones. Azure Data Factory es un servicio en la nube de Microsoft que proporciona herramientas para la orquestación y el movimiento de datos de forma eficiente. En este artículo, exploraremos cómo integrar datos de SharePoint en una base de datos utilizando Azure Data Factory.

¡Comenzamos!

La gestión de permisos en SharePoint es fundamental para controlar quién puede acceder, ver y editar los documentos. Además de los permisos a nivel de sitio y biblioteca, SharePoint ofrece permisos a nivel de elemento que permite definir quién puede acceder a cada archivo individualmente. Es importante tener en cuenta que los permisos en SharePoint pueden heredarse de niveles superiores o pueden ser asignados de forma independiente.

¿Qué es Linked Service de Azure Data Factory?

Un Linked Service en Azure Data Factory es una configuración de conexión que proporciona la información necesaria para acceder a una fuente de datos externa o un destino desde los flujos de trabajo de integración de datos en Azure Data Factory.

Creación de un Linked Service de SharePoint a Azure Data Factory

Al configurar un Linked Service de SharePoint en Azure Data Factory es importante saber que tipo de autenticación vamos a utilizar. Dependiendo de la configuración de seguridad de tu entorno SharePoint, es posible que necesites elegir entre diferentes métodos de autenticación, como la autenticación básica, la autenticación de Windows integrada o la autenticación basada en tokens.

¿Y un Linked Service de SQL Server?

Al configurar un Linked Service de SQL Server en Azure Data Factory, es esencial considerar aspectos de seguridad como la configuración de cifrado y la gestión de credenciales. Azure Data Factory admite la conexión segura a SQL Server mediante protocolos de cifrado como SSL/TLS para proteger la comunicación entre el servicio y la base de datos. Además, al configurar las credenciales de autenticación para el Linked Service, es recomendable utilizar opciones como el almacenamiento seguro de credenciales en Azure Key Vault para proteger las credenciales de forma segura y evitar la exposición accidental.

¿Cómo Crear Datasets de Azure Data Factory?

Los dataset de Azure Data Factory son una representación lógica de una colección de datos que proporcionan información sobre su ubicación, formato y configuración para su uso en flujos de trabajo de integración de datos.

Creación de un Dataset para el Fichero Excel en ADF

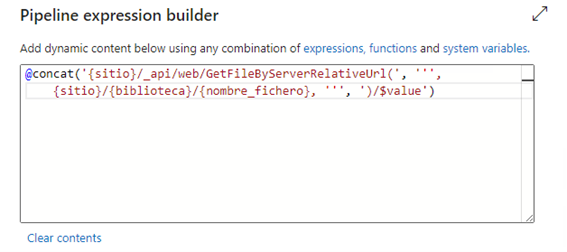

Al definir el dataset del Excel de SharePoint en Azure Data Factory deberás escoger la opción de tipo de dato binario HTTP ya que la conexión a SharePoint se hace a través de su API.

Aquí deberás configurar el Linked Service creado para la conexión con SharePoint y en URL Relativa deberás añadir la cadena hasta el archivo.

Creación de un Dataset de SQL Server en Azure Data Factory

Al configurar un Dataset de SQL Server en Azure Data Factory, es fundamental configurar el Linked Service como el creado anteriormente. Además, debemos revisar que el usuario de Azure Data Factory que recibirá la información tenga permisos de lectura y escritura sobre la tabla de SQL Server.

¿Qué es una Pipeline en Azure Data Factory? y, ¿cómo crearlo?

Las pipelines de Azure Data Factory son conjuntos de actividades que se ejecutan en una instancia de trabajo, dichas actividades son los distintos pasos que se realizan dentro de cada pipeline.

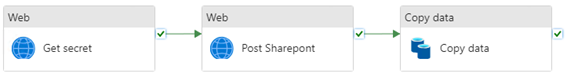

La pipeline definida está compuesta por tres actividades ya que, en nuestro caso, tenemos en Azure Key Vault las credenciales del Service Principal.

De esta forma, mediante una solicitud al Key Vault recogemos las credenciales del Services Principal que serán necesarias en la segunda actividad, cuando hagamos la llamada API a SharePoint y podamos acceder al archivo que necesitamos. Por último, se realiza la actividad de copia desde el Excel de SharePoint a la tabla de base de datos.

Programación y Ejecución de la Pipeline

Al programar y ejecutar la pipeline en Azure Data Factory, es importante considerar aspectos como la planificación de la carga de datos y la optimización del rendimiento. Dependiendo de la frecuencia de actualización de los datos y los requisitos de disponibilidad, puedes programar el Pipeline para ejecutarse en intervalos regulares, como diariamente, semanalmente o mensualmente.

Conclusión

En resumen, la integración de documentos Excel de una biblioteca de SharePoint en una base de datos SQL Server utilizando Azure Data Factory es un proceso complejo que requiere una cuidadosa planificación y configuración. Desde la configuración de permisos en SharePoint y SQL Server hasta la definición de Linked Services y Datasets en Azure Data Factory, cada paso del proceso juega un papel crucial en el éxito de la integración de datos. Al seguir las mejores prácticas de seguridad, diseño y gestión de datos, puedes aprovechar al máximo las capacidades de Azure Data Factory para crear flujos de trabajo de integración de datos robustos y escalables que impulsen la eficiencia operativa y la toma de decisiones en tu organización.