Esta publicación te guiará a través de los elementos esenciales para comenzar con Microsoft Real-Time Analytics (la Inteligencia en Tiempo Real de Microsoft Fabric). Descubrirás los componentes clave, como Real-Time Hub, Eventstream, Eventhouse, KQL Databases, etc.., que trabajan juntos para ofrecerte conocimiento o visión en tiempo real.

Trataremos casos de uso y pasos prácticos, verás cómo la analítica en tiempo real puede mejorar rápidamente la experiencia del cliente, optimizar operaciones y proporcionar una plataforma sólida para decisiones basadas en datos. Ya sea que estés iniciándote en el análisis de datos o buscando ampliar tus capacidades, esta guía te mostrará cómo aprovechar todo el potencial de los datos en tiempo real para beneficiar a tu negocio de inmediato.

En el entorno digital actual, las empresas generan datos constantemente desde múltiples fuentes, desde interacciones con clientes hasta procesos internos. Aprovechar estos datos en tiempo real es fundamental para mantenerse competitivo, mejorar la toma de decisiones y responder rápidamente a los cambios del mercado. La inteligencia en Tiempo Real de Microsoft Fabric frece un conjunto de herramientas potentes que permite a las empresas capturar, procesar y analizar datos al momento. Esta visión inmediata puede impulsar acciones significativas que aporten valor a tu negocio desde el primer día.

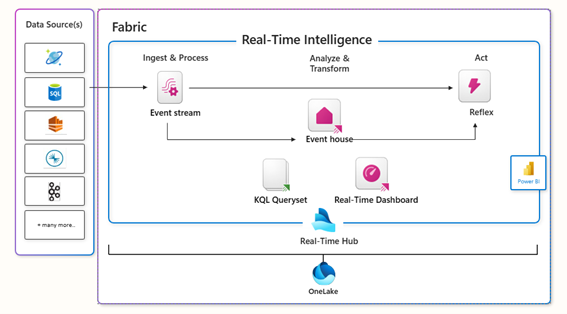

Resumen del flujo de trabajo en un escenario de tiempo real:

- Ingesta de Datos: ingesta de datos en tiempo real desde varias fuentes (Cosmos DB, SQL, Event Hubs, etc.).

- Procesamiento: Los datos pasan por la etapa de Ingesta y Procesamiento, donde se realizan las transformaciones y el análisis iniciales. El elemento utilizado para esta ingesta y procesamiento de datos es el Eventstream.

- Almacenamiento y Consulta: Los datos procesados se almacenan en Event House para un análisis intermedio. Este componente almacena los eventos procesados temporalmente, actuando como un almacenamiento intermedio o buffer donde se pueden consultar o procesar más a fondo mediante consultas KQL para analizar y transformar los datos.

- Gestión con el Real-Time Hub: El Real-Time Hub es una parte central de la arquitectura que permite encauzar y gestionar datos en tiempo real entre los componentes. Conecta los componentes de almacenamiento y procesamiento, facilitando el flujo continuo de datos.

- Almacenamiento Centralizado: OneLake almacena todos los datos procesados e históricos, haciéndolos accesibles para análisis.

- Visualización: Los datos se visualizan en el Dashboard en Tiempo Real o en Power BI.

- Acción: Reflex es un componente de acción que permite al sistema responder automáticamente a eventos o condiciones específicas en tiempo real. Podría activar alertas, notificaciones o flujos de trabajo automatizados basados en reglas definidas. Por ejemplo, si se detecta una anomalía, Reflex podría activar una alerta o iniciar una acción correctiva.

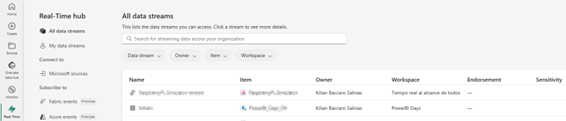

2. Real-Time Hub

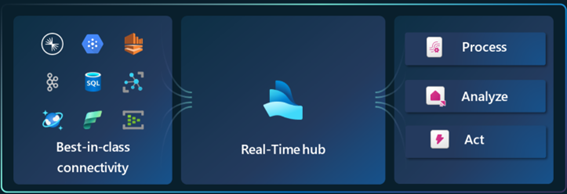

El Real-Time Hub o Centro en Tiempo Real es el lugar donde se encuentra todo lo relacionado con tiempo real en Microsoft Fabric. Te ayuda a conectarte a los distintos orígenes de datos soportados, a monitorizar y administrar los artefactos de la organización y te ayuda a actuar y reaccionar en tiempo real sobre los datos.

El Real-Time Hub consiste en tres elementos: Flujo de datos (data streams), fuentes de datos de Microsoft (Microsoft sources) y Eventos de Fabric (Fabric events).

- Flujo de datos: Es donde manejas toda la ingesta, transformaciones y todos los destinos de datos en Microsoft Fabric. Puedes administrar todo mediante event streams con fuentes externas desde Microsoft Fabric o con un custom endpoint mediante kafka, AMQP o Event hubs.

- Fuentes de datos de Microsoft: Todas las fuentes a las que tienes acceso se pueden ingerir, manejar o mantener directamente desde el Real-Time Hub. Estas fuentes pueden ser bases de datos cosmosdb, SQL, IoT Hubs, Event hubs, etc…

- Eventos de Fabric: Dos tipos de eventos. Se pueden obtener los eventos de un área de trabajo de Fabric y también de una cuenta de almacenamiento en Azure.

El equipo de inteligencia en Tiempo Real de Microsoft Fabric continúa desarrollando y agregando nuevos orígenes de datos, por lo que esto se ampliará y cambiará a lo largo del tiempo.

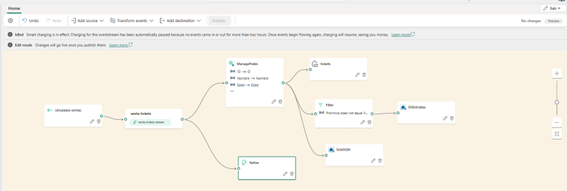

3. Eventstream

En Microsoft Fabric, el componente Eventstream es fundamental para habilitar el análisis en tiempo real al actuar como un canal continuo que captura, procesa y enruta eventos de datos a medida que ocurren. Está diseñado para proporcionar procesamiento de datos de baja latencia, permitiendo a las organizaciones generar conocimientos accionables y activar respuestas inmediatas.

Cuenta con un entorno lowcode en el cual puedes arrastrar y soltar diferentes elementos, como fuentes, transformaciones y destinos:

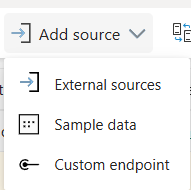

Orígenes

Los orígenes disponibles en Eventstream incluyen fuentes externas, datos de muestra o un punto de conexión personalizado:

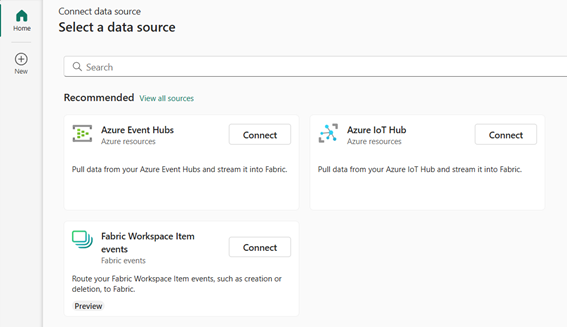

1. FUENTES EXTERNAS

Permite conectar y transmitir datos desde varios sistemas y servicios externos directamente a Microsoft Fabric, e incluye conectores a Azure Event Hubs, Azure IoT Hub y Kafka, que se utilizan comúnmente para manejar flujos de datos a gran escala en tiempo real. Las fuentes externas son ideales para organizaciones con canalizaciones de datos existentes o soluciones IoT que generan datos de alta frecuencia.

Por ejemplo, una organización que rastrea datos de sensores IoT para manufacturación podría conectar su IoT Hub directamente al Eventstream de Fabric.

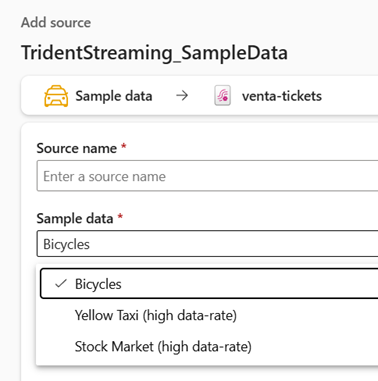

2. DATOS DE MUESTRA

Proporciona datos de muestra preconfigurados para pruebas y experimentación, simulando flujos de datos en tiempo real específicos, como datos transaccionales o eventos de clic.

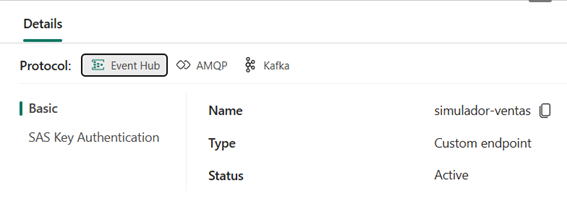

3. PUNTO DE CONEXIÓN PERSONALIZADO

Permite crear un endpoint REST personalizado que puede aceptar solicitudes HTTP y enviar datos al Eventstream, permitiendo ingestar datos desde casi cualquier sistema que soporte solicitudes HTTP, lo que lo hace muy versátil. Esto viene bien para aplicaciones personalizadas o escenarios donde necesitas enviar eventos o datos específicos a Fabric en tiempo real.

Por ejemplo, una aplicación web podría enviar datos de actividad del usuario (como clics en botones o vistas de páginas) directamente al Eventstream de Fabric.

These options provide flexibility to ingest data from established streaming services, use pre-configured sample datasets for quick testing, or set up custom sources for unique or one-off data needs.

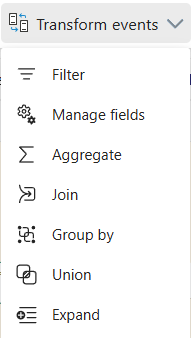

TRANSFORMACIONES

Puedes aplicar transformaciones a los datos dentro de Eventstream antes de enviarlos a su destino:

Aquí tienes un resumen de cada opción de transformación:

- Filtro: Esta transformación te permite filtrar eventos en función de condiciones específicas, de modo que solo los eventos que cumplen con esas condiciones continúan en el flujo. Por ejemplo, podrías filtrar para procesar solo eventos donde una lectura de temperatura excede un cierto umbral.

- Gestionar Campos: Esta opción te permite seleccionar, renombrar, tipificar o eliminar campos específicos en los datos entrantes. Por ejemplo, si tus datos incluyen campos adicionales que no necesitas, puedes eliminarlos para optimizar el procesamiento.

- Agregación: Con esta transformación, puedes realizar cálculos agregados en tus datos, como sumar valores, calcular promedios, contar u otras medidas estadísticas. Es útil para resumir datos en intervalos de tiempo, como calcular las ventas promedio cada minuto.

- Combinación: La operación de Combinación (join) permite combinar dos flujos diferentes basados en una clave común. Por ejemplo, si tienes flujos de eventos separados para transacciones de ventas y detalles de clientes, puedes unirlos según el ID del cliente para enriquecer los datos de transacción con información del cliente.

- Agrupar Por: Esta transformación permite agrupar eventos según uno o más campos y luego aplicar agregaciones en cada grupo. Por ejemplo, podrías agrupar por región y calcular las ventas totales para cada región en tiempo real.

- Unión: La Unión te permite fusionar múltiples flujos en uno al combinar eventos de diferentes fuentes o tablas que tienen el mismo esquema. Es útil cuando quieres procesar eventos de múltiples flujos como un flujo unificado.

- Expandir: Esta opción se usa para «aplanar» estructuras de datos anidadas. Si un campo contiene una estructura anidada (como un esquema en JSON), expandir la desglosará en registros individuales, facilitando el trabajo con datos complejos.

Cada una de estas transformaciones te ayuda a controlar y dar forma al flujo de datos para cumplir con requisitos específicos de análisis, permitiendo análisis en tiempo real más flexibles y dirigidos dentro de Eventstream de Microsoft Fabric.

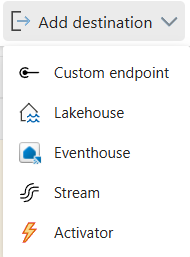

DESTINOS

Eventstream te permite enviar datos procesados a varios destinos donde pueden almacenarse, analizarse o visualizarse. Estos son los principales destinos disponibles para Eventstream:

- Punto de Conexión Personalizado: Esta opción te permite enviar datos a un endpoint HTTP personalizado a través de un webhook, proporcionando flexibilidad para integrarse con aplicaciones de terceros, API externas o cualquier sistema que acepte solicitudes HTTP.

Este destino es ideal para integraciones personalizadas donde quieras enviar eventos a otra aplicación o servicio que no está directamente soportado por Microsoft Fabric.

Por ejemplo, podrías usar un punto de conexión personalizado para enviar datos a un sistema CRM externo.

- Lakehouse: Permite almacenar datos en un Lakehouse de Fabric, diseñado para manejar datos estructurados y no estructurados. Lakehouse ofrece almacenamiento escalable y está optimizado para análisis a gran escala, soportando retención de datos a largo plazo y análisis.

Este destino es adecuado para escenarios donde necesitas almacenar datos en tiempo real para procesamiento por lotes, ciencia de datos o tareas de aprendizaje automático.

Por ejemplo, una empresa minorista podría almacenar registros de transacciones en un Lakehouse para analizar tendencias de compra posteriormente.

- Eventhouse: Un Eventhouse está diseñado específicamente para la ingesta de eventos en tiempo real y está optimizado para el rendimiento de consultas en datos en streaming. Permite almacenar datos en tiempo real directamente en una base de datos KQL (Kusto Query Language) dentro de Microsoft Fabric.

- Las bases de datos KQL están optimizadas para consultas rápidas y son particularmente adecuadas para cargas de trabajo de análisis en tiempo real, facilitando el trabajo con grandes volúmenes de datos en streaming. Puedes usar KQL para análisis detallados, detección de anomalías y reconocimiento de patrones en los datos almacenados. Este tipo de base de datos es ideal para escenarios en los que necesitas ejecutar consultas complejas sobre los datos entrantes o retener datos a lo largo del tiempo para análisis históricos.

Por ejemplo, una empresa de manufacturación puede almacenar datos de sensores en una base de datos KQL para detectar tendencias y prevenir fallos en equipos.

- Stream: Esta opción te permite enviar datos de un Eventstream a otro, encadenando los flujos, lo cual habilita flujos de procesamiento avanzados al desglosar el procesamiento de datos en múltiples etapas o flujos. Es útil para flujos de trabajo complejos donde los datos necesitan procesarse en etapas.

Por ejemplo, un flujo podría filtrar y agregar datos, mientras que otro aplica transformaciones o enriquecimientos adicionales.

- Activator: El destino Activator se utiliza para lanzar acciones basadas en condiciones o umbrales de datos en tiempo real, permitiendo respuestas automatizadas o alertas cuando ocurren eventos específicos en tiempo real.

Por ejemplo, una empresa de seguridad podría usar el Activator para detectar actividades sospechosas y activar automáticamente alertas o acciones cuando se cumplen ciertos umbrales.

Estos destinos ofrecen una variedad de opciones de almacenamiento, integración y procesamiento, permitiéndote elegir el destino adecuado según tus necesidades de análisis de datos en tiempo real.

4. Eventhouse

El Eventhouse es un componente fundamental para gestionar y procesar datos en tiempo real. Es compatible con datos no estructurados, semi-estructurados y estructurados. Esencialmente, proporciona una estructura optimizada para manejar flujos de eventos muy continuos, lo que es crucial en aplicaciones que dependen de los datos en tiempo real, como la detección de fraudes o en monitorización de IoT.

CARACTERÍSTICAS PRINCIPALES

El Eventhouse es un componente fundamental para gestionar y procesar datos en tiempo real. Es compatible con datos no estructurados, semi-estructurados y estructurados. Esencialmente, proporciona una estructura optimizada para manejar flujos de eventos muy continuos, lo que es crucial en aplicaciones que dependen de los datos en tiempo real, como la detección de fraudes o en monitorización de IoT.

OPTIMIZADO PARA EL FLUJO DE DATOS SIN INTERVENCIÓN DEL USUARIO

Eventhouse está diseñado para ingerir datos en tiempo real de forma altamente eficiente, con un almacenamiento optimizado para mantener una latencia mínima. No se requiere configuración adicional para optimizar o mejorar el rendimiento; basta con crearlo para que esté inmediatamente disponible y listo para su uso.

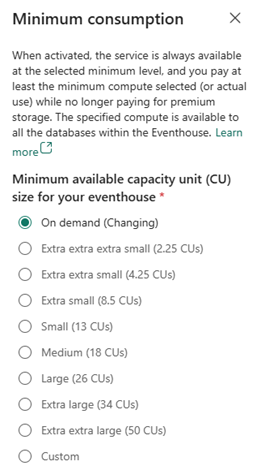

SERVERLESS

Eventhouse está diseñado para optimizar costos al suspender automáticamente el servicio cuando no está en uso. Esto significa que, en ausencia de flujo de datos entrante, el cómputo de consultas KQL se detiene temporalmente. Al reactivarse, podría experimentarse una latencia de unos segundos. Para entornos donde esta latencia es crítica, se recomienda habilitar la configuración de consumo mínimo, lo cual garantiza que el servicio esté siempre activo en un nivel mínimo predefinido hasta que se reanude el flujo de datos y se restaure el consumo estándar. La siguiente imagen muestra los diferentes niveles de consumo mínimo disponibles:

HOT Y COLD CACHÉ

Eventhouse ofrece dos modos de almacenamiento de datos: almacenamiento en caché (hot tier) y almacenamiento estándar (cold tier). Para garantizar un rendimiento óptimo en las consultas, el sistema de caché, o hot tier, almacena los datos en SSD o incluso en memoria RAM. Sin embargo, este alto rendimiento implica un costo adicional, comparable al nivel premium de Azure Data Lake Storage, debido al mayor precio del almacenamiento en caché.

Los datos ubicados en el almacenamiento estándar o cold tier resultan más económicos, aunque su acceso es más lento. Es fundamental definir una directiva de caché adecuada para trasladar al almacenamiento estándar aquellos datos que no requieren análisis frecuente o que no son críticos. Por otro lado, mantener en caché los datos de alta relevancia asegura su disponibilidad para un análisis inmediato y cercano al tiempo real.

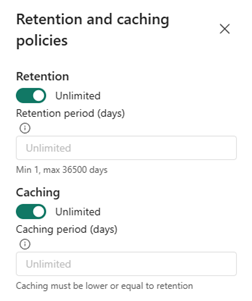

DIRECTIVAS DE RETENCIÓN DE DATOS Y CACHÉ

La directiva de retención gestiona la eliminación automática de datos en tablas o vistas materializadas, lo cual resulta especialmente útil para remover datos continuos cuya relevancia disminuye con el tiempo.

La implementación de una directiva de retención es esencial al ingerir datos de manera continua, ya que permite gestionar costos eficientemente.

Los datos que exceden el periodo definido por la directiva de retención se consideran elegibles para eliminación. Sin embargo, no existe una garantía exacta sobre cuándo se llevará a cabo dicha eliminación; los datos pueden permanecer incluso después de que se active la directiva.

En general, la directiva de retención se establece para limitar la antigüedad de los datos desde el momento de su ingesta.

Para optimizar el rendimiento de las consultas, se implementa un sistema de caché de datos en múltiples niveles. Aunque los datos se almacenan en un almacenamiento seguro y confiable, una parte de ellos se guarda en caché en nodos de procesamiento, unidades SSD o incluso en RAM para garantizar un acceso más rápido.

La política de caché permite especificar qué datos deben mantenerse en caché, diferenciando entre datos calientes y fríos. Al establecer una política de caché para los datos calientes, estos se guardan en almacenamiento local SSD, lo cual acelera las consultas, mientras que los datos fríos permanecen en un almacenamiento confiable, que resulta más económico, pero con un acceso más lento.

El rendimiento óptimo de las consultas se alcanza cuando todos los datos ingeridos están en caché. Sin embargo, no todos los datos justifican el costo de mantenerse en caché en la capa de datos calientes.

BASE DE DATOS KQL

Eventhouse trabaja con bases de datos KQL (Kusto Query Language). Una base de datos KQL es un tipo de base de datos optimizada para el análisis de grandes volúmenes de datos en tiempo real, utilizando KQL, un lenguaje de consulta desarrollado por Microsoft para realizar búsquedas y análisis de datos en servicios como Azure Data Explorer y Microsoft Fabric.

Un Eventhouse puede contener varias bases de datos KQL.

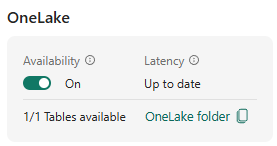

DISPONIBILIDAD EN ONELAKE

Una de las características más importantes de KQL es la de la disponibilidad en OneLake. Activando esta característica, los datos de KQL están disponibles en OneLake y se pueden coonsultar los datos en formato Delta Lake mediante otros motores de Fabric, como Direct Lake en Power BI, Warehouse, Lakehouse, Notebooks, etc.

También tienes la posibilidad de crear un acceso directo de OneLake desde un Lakehouse o Warehouse.

Hay que tener en cuenta que esta característica evita escribir muchos archivos Parquet pequeños, lo que puede retrasar las operaciones de escritura horas si no hay suficientes datos para crear archivos Parquet óptimos. Esto garantiza que los archivos Parquet sean óptimos en tamaño y no haya problemas de rendimiento a la hora de consultarlos.

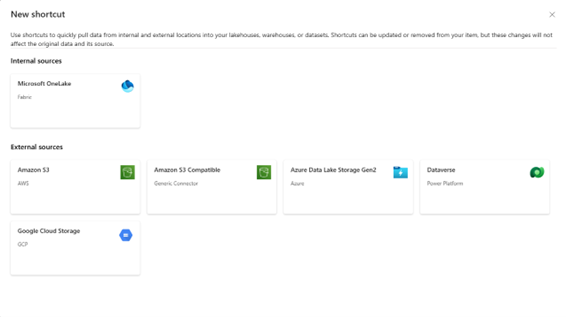

ACCESOS DIRECTOS

Los accesos directos son referencias dentro de OneLake que apuntan a ubicaciones de otros archivos sin mover los datos originales. En una base de datos KQL también se pueden crear accesos directos que apunten a orígenes externos o internos de Fabric.

Una vez creado el acceso directo, en la consulta de datos se hace referencia a él mediante la función external_table()

external_table(‘customer’)

| count

ventas

| join kind=inner external_table(‘date’) on $left.DateKey == $right.DateKey

| join kind=inner external_table(‘store’) on $left.StoreKey == $right.StoreKey

| project OrderKey, OrderDate, MonthShort, StoreCode, CountryName

Actualmente, los accesos directos permitidos son:

- OneLake

- Azure Data Lake Storage Gen2

- Amazon S3

- Dataverse

- Google Cloud Storage

KQL QUERYSET

Para realizar consultas sobre los datos de una base de datos KQL se utilizan las KQL Queryset con el lenguage Kusto Query Language.

Kusto Query Language (KQL) es un lenguaje de consulta desarrollado por Microsoft para trabajar con grandes volúmenes de datos, especialmente en contextos de análisis en tiempo real. Fue creado para interactuar con bases de datos como Azure Data Explorer y ahora con Microsoft Fabric, que están diseñadas para almacenar y analizar datos masivos de series temporales, eventos de telemetría, registros de aplicaciones y otros datos generados en tiempo real.

ventas

| where OrderDate >= ago(7d)

5. DASHBOARD EN TIEMPO REAL

La obtención y el procesamiento de datos en tiempo real son tan cruciales como las herramientas que permiten visualizar dicha información. Los cuadros de mando en tiempo real ofrecen a los usuarios la capacidad de interactuar con sus datos al instante.

Cada gráfico de estos cuadros está vinculado a consultas KQL, las cuales pueden ser editadas y configuradas para optimizar la visualización de los datos. Además, incluyen parámetros, filtros y funciones de navegación para explorar datos con mayor detalle.

Como los gráficos visuales son un reflejo de los datos almacenados en Eventhouse y aprovechando la disponibilidad de los datos con baja latencia, los cuadros de mando son ideales para los escenarios en los que la exploración de los datos debe ser inmediata y predomina la experiencia en KQL.

6. REAL-TIME ARCHITECTURES

En Microsoft Fabric, existen varias opciones de arquitectura de datos en tiempo real para Power BI y otros servicios, cada una diseñada para manejar diferentes tipos de requisitos de análisis en tiempo real.

Para estos escenarios, asumimos que tenemos nuestras tablas de dimensiones en un Lakehouse y que la tabla de hechos llega en tiempo real y es procesada por nuestro Eventstream.

A continuación, se presenta una descripción de algunas arquitecturas comunes.

DIRECTLAKE MODE IN POWER BI

El modo DirectLake en Power BI es una función que permite a Power BI conectarse directamente a un lago de datos (Lakehouse de Fabric) sin necesidad de importar o pre-agregar los datos.

En este ejemplo, el destino de nuestro Eventstream será un Lakehouse, y nos conectaremos en modo DirectLake en Power BI para consultar nuestras tablas de dimensiones y nuestra tabla de hechos.

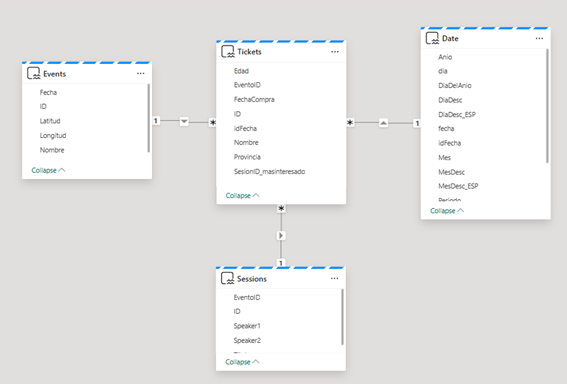

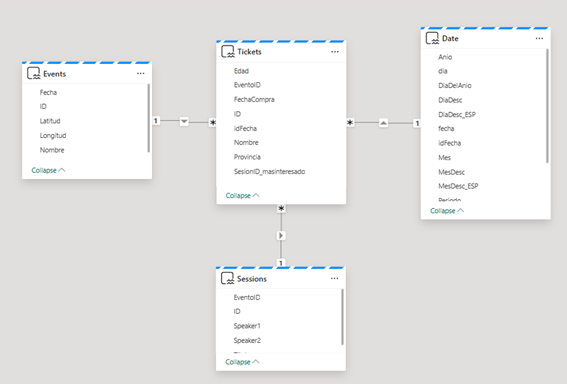

Este es el modelo semántico:

Tenemos nuestra tabla de hechos «Tickets» que se carga desde nuestro Eventstream, almacenando los datos en nuestro Lakehouse.

Esta arquitectura permite un acceso casi instantáneo a grandes volúmenes de datos con baja latencia, ya que evita el proceso de importación de datos. Este modo también ofrece la flexibilidad de consultar directamente datos en tiempo real almacenados en formato Delta Lake en un Lakehouse.

Sin embargo, un posible inconveniente de este enfoque es que la carga de la tabla de hechos en el Lakehouse a través de Eventstream generará numerosos archivos pequeños. Para mantener un rendimiento óptimo, será necesario implementar un proceso de mantenimiento para consolidar estos archivos pequeños en archivos más grandes, ya que un exceso de archivos pequeños puede degradar el rendimiento.

MODO MIXTO CON MODO IMPORT Y DIRECT QUERY A UNA BASE DE DATOS KQL

El modo mixto combina tanto el modo Import como DirectQuery en Power BI, permitiendo que algunos datos se importen (en caché para un rendimiento rápido) mientras que otros se consultan en tiempo real directamente desde una base de datos KQL (Kusto).

Para este ejemplo, el destino de nuestro Eventstream será una base de datos KQL. Nos conectaremos en modo DirectQuery en Power BI para consultar nuestra tabla de hechos en la base de datos KQL, y para las dimensiones usaremos el modo Import, para obtener las tablas desde nuestro Lakehouse.

Este es el modelo semántico:

Para conectarse a una base de datos KQL, haz clic en Obtener Datos:

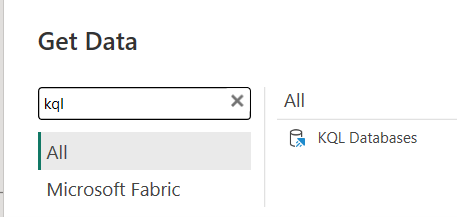

Busca KQL Database en el menú de la derecha:

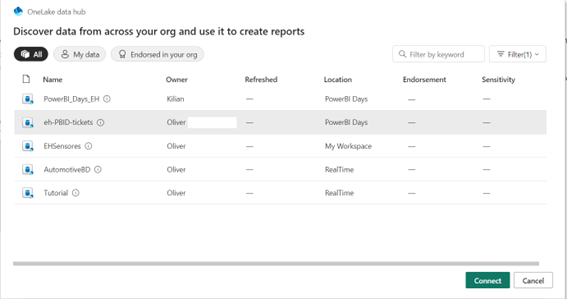

Selecciona tu base de datos KQL y haz clic en Conectar:

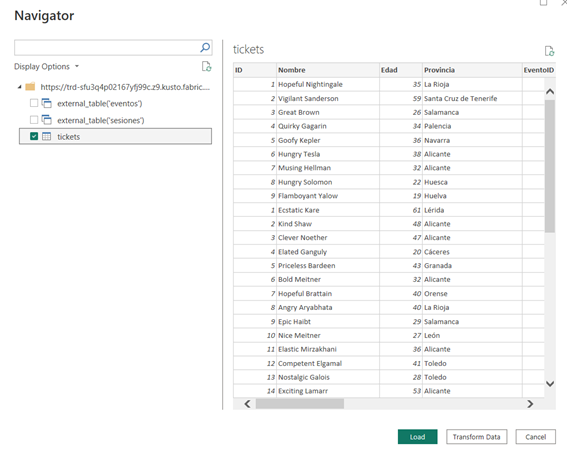

Luego, puedes seleccionar tu tabla y hacer clic en Cargar o clic en Transformar Datos si deseas hacer algunos cambios:

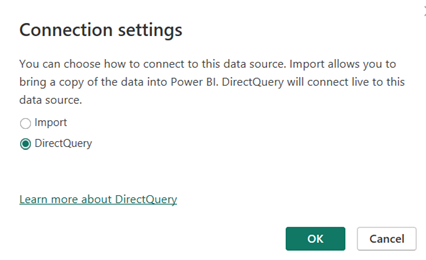

Selecciona el modo DirectQuery y haz click en OK:

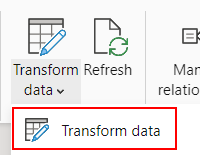

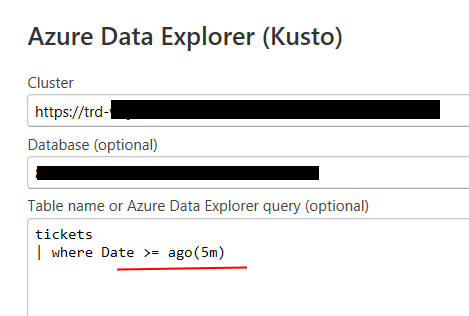

Después, puedes personalizar tu consulta; por ejemplo, si solo quieres los tickets de los últimos cinco minutos, haz clic en Transformar datos, en el menú superior de Power BI:

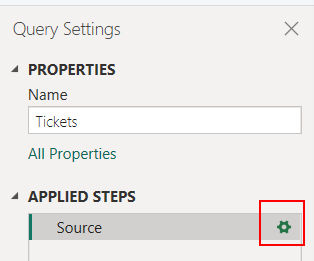

Selecciona tu tabla en el panel izquierdo y luego selecciona el icono del engranaje en tu panel derecho:

Después de eso, puedes cambiar tu consulta para cargar solo los últimos cinco minutos, utilizando la sintaxis KQL:

Este enfoque proporciona la flexibilidad de usar el modo Import para datos que se actualizan con poca frecuencia, como es el caso de las dimensiones, asegurando un alto rendimiento, mientras que accedes a datos en vivo a través de DirectQuery cuando es fundamental tener información actualizada.

Las ventaja de esta arquitectura es que, al usar la base de datos KQL, que está optimizada para consultas de datos en tiempo real, proporciona una gran flexibilidad para consultar y analizar datos con un rendimiento excelente, permitiéndote ver resultados casi al instante en tu informe en Power BI.

Dashboard EN TIEMPO REAL

Con este enfoque, puedes crear un Panel en Tiempo Real fijando (pineando) directamente consultas KQL. En este ejemplo, vamos a fijar algunas consultas para mostrarte algunos ejemplos, y también crearemos accesos directos (shortcuts) en la base de datos KQL para obtener nuestras dimensiones desde nuestro Lakehouse y luego combinar nuestra tabla de hechos de la base de datos KQL con nuestras dimensiones del Lakehouse.

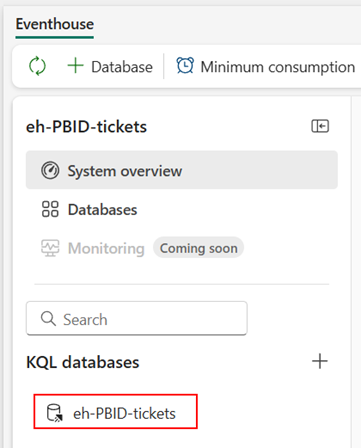

Para hacerlo, primero vamos al Eventhouse en nuestro espacio de trabajo de Fabric y luego, dentro de nuestro Eventhouse hacemos clic en nuestra base de datos KQL:

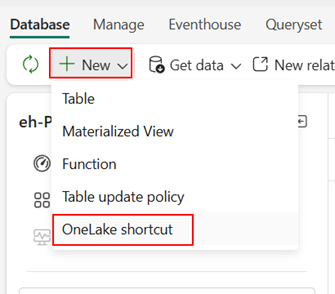

Una vez que estamos dentro de nuestra base de datos KQL, vamos a añadir Shortcuts para obtener nuestras tablas de dimensiones, para ello, clic en Nuevo -> OneLake shorcut:

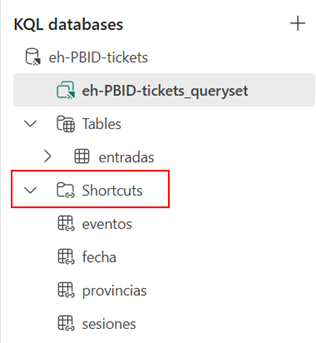

Luego, seleccionamos nuestro Lakehouse y seleccionamos la tabla a cual queremos aplicarle el acceso directo, una vez añadida la tabla nos aparecerá en el menú desplegable de Shortcuts:

Y ahora, estás listo para escribir consultas KQL y fijarlas en el Dashboard.

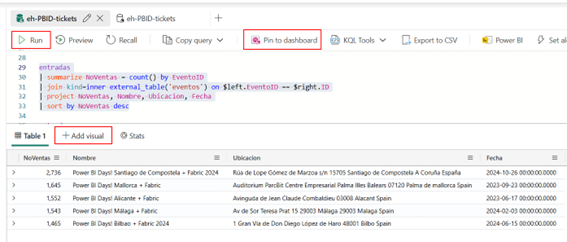

En este ejemplo, escribiremos una consulta para obtener los tickets, uniéndolos con nuestra tabla de dimensión de eventos, y agrupamos para contar el número de tickets vendidos en cada evento:

Selecciona la consulta y haz clic en Ejecutar para ver los resultados; después, puedes hacer clic en Fijar en el panel, puedes cambiar tu visualización haciendo clic en +Agregar visualización si deseas cambiarla por otra, por ejemplo, un mapa o un gráfico de columnas.

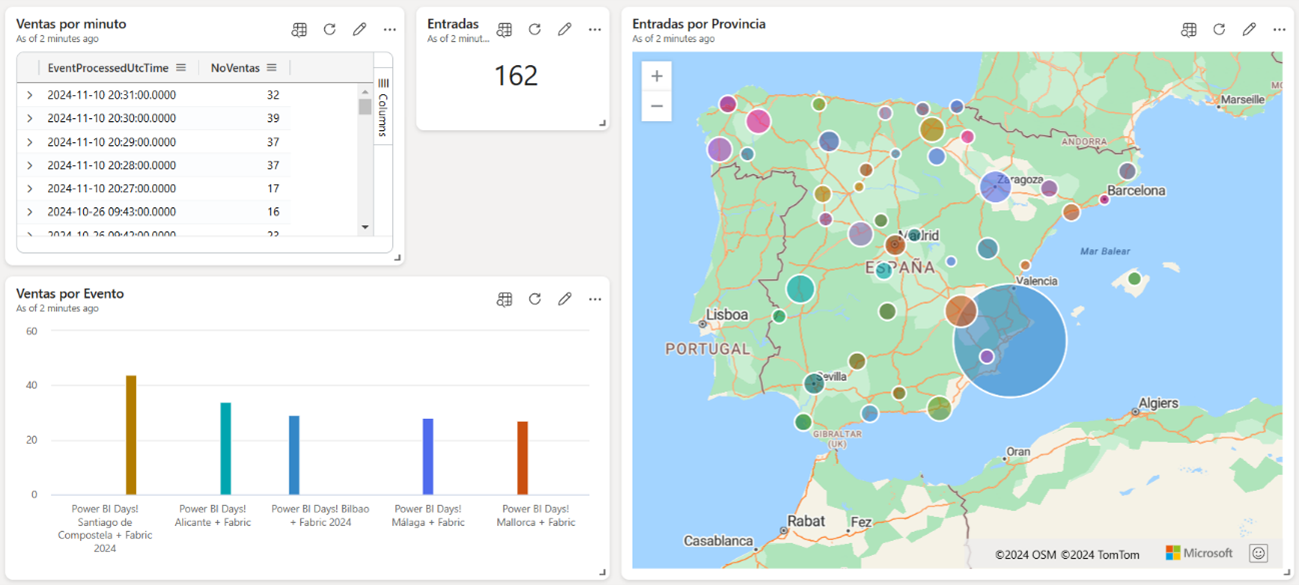

Y este es el resultado después de fijar algunas consultas en nuestro Dashboard en tiempo real:

Este método es adecuado para escenarios de monitoreo donde la retroalimentación en tiempo real es esencial.

Por ejemplo, una empresa de logística podría usar un conjunto de datos en tiempo real para monitorizar la ubicación de vehículos en tiempo real, mientras almacena datos históricos para un análisis posterior.

ELECCIÓN DE LA ARQUITECTURA CORRECTA

- Para análisis casi instantáneos con datos ya almacenados en un Lakehouse: El modo DirectLake es a menudo la mejor opción.

- Para un equilibrio entre analisis en tiempo real y rendimiento con algunos datos en caché: El modo mixto (Import + DirectQuery) proporciona flexibilidad para dashboards que necesitan tanto acceso rápido a datos históricos como actualizaciones en tiempo real.

- Para visualizaciones de latencia ultrabaja o dashboard de monitorización: Los paneles en tiempo real con conjuntos de datos push o streaming son ideales, especialmente para monitorizar métricas operativas como datos de IoT, precios de acciones o tendencias en redes sociales.

Cada una de estas arquitecturas puede elegirse en función de tus requisitos de latencia, volumen de datos, necesidades de almacenamiento y expectativas generales de rendimiento de tu informe.

Conclusion

Implementar la inteligencia en Tiempo Real de Microsoft ofrece a las empresas una poderosa herramienta para desbloquear el valor de sus datos de manera instantánea. Al configurar flujos de trabajo de ingesta, procesamiento y visualización en tiempo real, las organizaciones pueden tomar decisiones oportunas, optimizar operaciones y responder proactivamente a las demandas del mercado.

Ya sea que elijas aprovechar Eventstream para un flujo continuo de datos o bases de datos KQL para consultas rápidas, la flexibilidad de Microsoft Fabric te permite adaptar soluciones que se alineen con las necesidades específicas de tu negocio.

A medida que aumentan los volúmenes de datos y se intensifica la demanda de conocimientos casi inmediatos, la inteligencia en Tiempo Real de Microsoft está preparada para enfrentar los desafíos del panorama actual impulsado por los datos. Con la configuración adecuada, puedes transformar datos en bruto en conocimientos accionables desde el primer día, lo que permite a tu organización mantenerse a la vanguardia, mejorar la experiencia del cliente y lograr resultados significativos.

Es el momento de adoptar el poder de los datos en tiempo real y aprovechar su potencial para moldear el futuro de tu negocio.